MEVLÜT TEZEL / Ünlüleri taklit eden videolara dikkat!

Yapay zeka üretimi sahte deepfake videoları ilk ortaya çıktığında anlamak kolaydı.

Bozuk yüz oranları, bulanık detaylar, gölgelerdeki tezatlar, hatalı dudak senkronizasyonu vs. görünce videonun sahte olduğunu anlıyorduk.

Ancak son çıkan yapay zeka destekli videoların sahte olduğunu almak çok zorlaştı.

Yapay zeka üretimi deepfake’ler artık insan gözünü yanıltacak kusursuzluğa ulaştı.

Uzmanlar, artık birçok insanın deepfake videolarının sahte olduğunu anlamasının zor olduğu konusunda uyarılar yapıyorlar.

Türkiye’de de yapay zekayla ünlüleri taklit ederek hazırlanan videolardaki sahte yatırım reklamlarına kanan vatandaşların sayısı arttı.

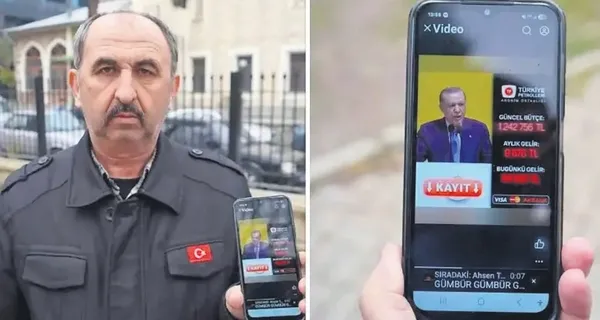

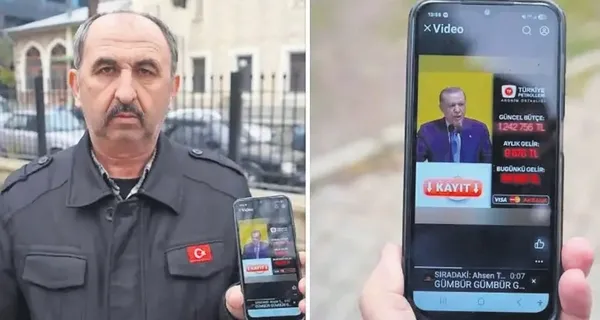

Bunun son örneği; Sakarya’da yaşandı.

56 yaşındaki İrfan Sezgin, yapay zeka ile hazırlanmış Cumhurbaşkanı Recep Tayyip Erdoğan‘ın görüntüleri ve sesinin kullanıldığı sahte reklamlarla 2,5 milyon lira dolandırıldı.

‘SERDAR ORTAÇ ARADI!’

En absürt örnek ise ünlü şarkıcı Serdar Ortaç‘ın sesinin yapay zeka ile taklit edilerek kendisinin aranmasıydı.

Ortaç yaşadıklarını şöyle anlattı:

“Geçen gün beni Serdar Ortaç aradı. Açtım telefonu, ‘Merhaba, ben Serdar Ortaç. İddia kuponunuz hazır, şu maça bahis oynayacak mısın?’ dedi. Konuşuyorum ama meğer robotmuş. Adam konuşuyor ama ben! Ben bile kendime inandım.

Düşünsene, akşam annemi arasa ‘Oğlunun cenazesi saat 14.00’te kalkıyor’ dese, kadın cenazeye gidecek. Ben tabutta yokum!

Yani nasıl bir şey bu? Kendi sesimden ‘İddia oynayacak mısın?’ diyor adam. Ben söylüyormuşum gibi.”

Geçtiğimiz günlerde Düzce merkezli beş ilde yapay zeka teknolojisiyle ünlü isimleri taklit ederek hazırladıkları sahte yatırım reklamlarıyla vatandaşları dolandıran şebekeye operasyon düzenlendi.

Yakalanan 5 şüphelinin hesabında 25 milyon liralık işlem hareketi belirlendi.

Geçtiğimiz ocak ayında Fransa’da da ‘Anne’ adlı 53 yaşındaki bir mimar kadın, Brad Pitt‘in mesajlarını ve yapay zeka tarafından üretilmiş fotoğraflarını gönderen bir dolandırıcı tarafından kandırılmıştı. Güya Brad Pitt, kadına evlenme teklif etmiş ama hastaneden yolladığı videolarda böbrek kanseri olduğunu ve paraya ihtiyacı olduğunu söylemiş.

Bahanesi de Pitt’in eski eşi Angelina Jolie‘nin banka hesaplarını dondurmuş olmasıydı.

Kadın da yapay zeka videolara inanıp Türkiye’deki bir hesaba tam 800 bin euro transfer etti, iyi mi?

Pitt’in sözcüsü, “Aynı yöntemle iki İspanyol kadın daha dolandırıldı. Dolandırıcıların hayranların ünlülerle kurduğu güçlü bağdan faydalanması korkunç bir şey” diye bir açıklama yayınlamıştı.

Bunlar gibi daha birçok ünlünün sahte yapay zeka videolarını gerçek sanıp dolandırılan birçok insan var.

Serdar Ortaç bile yapay zeka videosu için “Ben bile kendime inandım” diyorsa durum ciddi!

Vatandaşların bu konuda uyanık olmaları bile yetmeyebilir!

Teknoloji şirketleri ve hükümetler, gerçeği sahte olandan ayırabilmek için yeni önlemler almaya çalışıyor.

NASIL ANLAYACAĞIZ?

Peki, ses klonlama, sahte görüntü ve videolarla yapılan dolandırıcılık denk gelirsek ne yapmalıyız?

Güvenlik uzmanı Perry Carpenter, teknik ayrıntılardan çok içeriklerin yol açtığı duygusal etkilere odaklanmak gerektiğini söylüyor.

Korku, panik, aciliyet ya da otorite hissi uyandıran paylaşımlar onun için birer uyarı sinyali.

Carpenter’a göre yapılabilecek en etkili şey, bu duygular devreye girdiğinde bilinçli biçimde yavaşlamak ve içeriği sorgulamak.

Uzmanlar Deepfake videolardan bazıları göz kırpma gibi doğal akışta gerçekleşen davranışları başarıyla taklit etmekte zorlandığını belirtiyor.

Gözlerin kırpılması esnasında meydana gelen düzensizlik, gözlerin duygusal ifadelerle uyumsuz olması, beklenmedik bir şekilde uzun süre açık kalan gözler gibi etkenler deepfake belirtileri olabilir.

Kişinin ses tonunda robotik, kendini tekrarlayan ifadelerden bir videonun sahte olduğunu tespit etme olasılığınız var. Ayrıca videolarda hareketler, kişilerin hareket tarzı ve ritmi tam anlamıyla uyum sağlamayabilir. Elbette sahte unsurları anlamak deepfake videosunun kalitesine bağlı.

Yukarda da bahsettiğim gibi; yapay zeka teknolojisindeki gelişmeler deepfake videoları her geçen gün daha kusursuz yapıyor.

KADINLAR VE ÇOCUKLAR TEHDİT ALTINDA

Araştırmalar, deepfake videolardaki tehdidin bireysel vakaların çok ötesine geçtiğini gösteriyor.

Okuduğum bir haberde deepfake videolar ile kurumlara yönelik saldırılar ve manipülasyon operasyonları da artığından bahsediliyordu:

Üstelik bu teknolojilere erişim de kolaymış.

Dolandırıcılar bugün, sentetik yüzlerden sahte seslere, dijital geçmişlerden sosyal medya profillerine kadar her şeyi içeren hazır “persona paketleri” satın alabiliyor.

Bu durum biyometrik koruma yöntemlerini de zorluyor.

Deepfake saldırıları, artık her beş biyometrik dolandırıcılık girişiminden birinde rol oynuyor.

Deepfake teknolojisinin yaygınlaşması, kadınlara ve çocuklara yönelik dijital istismar vakalarını da artırmış durumda.

Internet Watch Foundation verilerine göre, yapay zekâ ile üretilmiş çocuk istismarı içeriklerine dair raporlar yalnızca bir yıl içinde iki kattan fazla arttı.

Uzmanlar, özellikle “çıplaklaştırma” uygulamalarının hızla yayılmasına dikkat çekiyor.

Yani sıradan insanların görselleriyle çok rahat erotik film bile oluşturup şantaj yapıyorlar.

Bu videolar yüzünden birçok kadın mağdur oldu.

Siyasi liderlerin sahte videolarıyla toplumsal karışıklık bile çıkartabilirler!

Yapay zeka videolara büyük kısıtlama getirilse şaşırmam.

Altyazı

“Hepimiz ölüme doğru koşuyoruz, ama yine de şu an için buradayız, hayattayız. Hepimiz öleceğimizi biliyoruz ama yine de gizlice ölmeyeceğimize inanıyoruz.” (Synecdoche, New York)